サイト内の現在位置

NEWS

The 38th Annual AAAI Conference on Artificial Intelligence レポート

DATE:2024.03.27

研究テーマ:人間拡張研究

2024年2月21日から27日にかけて開催されたThe 38th Annual AAAI Conference on Artificial Intelligence(以下、AAAI-24)について、現地で参加してきましたのでその様子をご紹介します。

The 38th Annual AAAI Conference on Artificial Intelligence

AAAI-24は、アメリカの人工知能学会であるAAAI(Association for the Advancement of Artificial Intelligence)が開催する第38回年次カンファレンスです。人工知能の研究促進及び研究者やエンジニア、学生などの交流促進を目的に掲げています。

今回のカンファレンスでは、投稿論文は10504件、論文採択率は全体でおよそ24%でした。国別論文投稿数の上位10ヵ国(不明含む)における投稿割合は、中国が約48%を占めて1位となっており、3位のアメリカ(約10%)の4~5倍の投稿数となっていました。

また、本カンファレンスのスポンサーにアメリカの企業であるAmazonやGoogle、IBMなどが名を連ねる中、HUAWEIやBaiduといった中国の企業の名前も見られ、AIに対する注目度の高さを感じます。

生成AI・マルチモーダルAIの応用事例

オープニングセッションでは、投稿論文のトピックスを表したワードクラウドが紹介されました。

「Transformer」と同程度の大きさで「Multi」や「Generation」といった単語があり印象的でした。

数ある発表の中でも興味深かった、生成AI・マルチモーダルAIを活用した企業の発表を紹介いたします。

Acceleration AVs with the Next Generation of Generative AI:Raquel Urtasun(Waabi)

招待講演として、自動運転トラック輸送技術を開発するカナダのスタートアップ企業Waabiが発表を行いました。

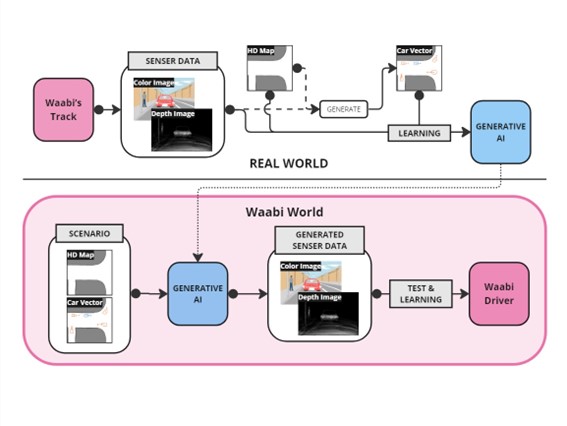

Waabiの特徴は、生成AI技術を組み込んだ独自の自動運転シミュレーター「Waabi World」を用いて、自動運転システム「Waabi Driver」のテスト及び学習を仮想世界上で行っていることです。

これまでの自動運転システムは開発サイクルが遅い点や、特殊な状況や問題を特定するための実世界での大量の走行テストが必要である点、未知の状況への汎化が難しい点が課題でした。

対してWaabiは、シミュレーター上で再現した様々な道路上の状況から生成AI技術を用いてセンサーデータを生成することで、仮想世界上で自動運転システムのテスト・学習を実現しており、これによって開発速度や自動運転性能を高めているとしています。

最も特徴的な点は、これまで実世界で取得する必要があったセンサーデータをシミュレーター上で生成していることでしょう。

生成AIモデル:実空間のデータとしてトラックに搭載されたカメラ及びLiDERのセンサーデータ、HD Mapとそこから作成した車両群データを学習

シミュレーター:Waabi World上の仮想道路状況(HD Map及び車両群データ)から、カメラ及びLiDERのセンサーデータを生成し、テスト・学習に利用

これによって、少量の実世界データから仮想世界上で再現した様々な状況のデータを生成することができ、大量のテストデータや汎化といった従来課題を解決しています。

元データで直進していた前方の車両が、違和感なく車線変更する生成動画はとても印象に残りました。

Toward Foundational Manipulation Skills(Dieter Fox, University of Washington and NVIDIA)

次に、AAAI-24内で開催されていた姉妹カンファレンスであるIAAIの招待講演の内容をご紹介します。

ロボット制御と生成AIをテーマに、ロボット工学者であるDieter Foxが講演を行いました。

ヘルスケアや製造においてロボットが人間とともに安全に作業を行うために、ロボット制御は欠かせないものです。そのためには物体認識や高度なコントロールなど様々な要素が必要となりますが、同時にさまざまな課題もあります。

これに対して、大量の学習データを生成することができれば、生成AIモデルを用いて汎用的な制御スキルを獲得することが出来るのではないかという仮説を立てています。

2020年の研究では、シミュレータ上でロボットアームに大量のタスクを実施させ、そのデータを元に形状からアームで掴むべき箇所を算出するモデルを作成しています。このモデルは、画像から推定された未知の形状に対して、およそ88%で掴むことに成功するようです。

また、続く2023年の研究では、テキストによる指示からLLMを用いてタスクを生成しロボットアームを制御することに成功しています。デモでは、「Sort the fruits on the plate and the bottles in the box」という文章が与えられ、LLMによって生成された3つタスクをロボットアームが実行する様子を見ることが出来ました。

ロボットアームの汎用的な制御スキルを生成AIが担うことで、人間側に専門的で複雑な操作をする必要がなくなり、また音声やテキストといったインターフェースで誰もがロボットを制御できるようになるかもしれません。

また、周囲の状況からリアルタイムにタスクを生成するという観点では、ロボットが人間側を認識・推定することであらたな共同作業が可能となるかもしれません。実際にデモ映像は、消毒用アルコールを押下するタスクを、人間の手がノズルの下に来るまで待って実行するなど、十分な対応力を感じられる内容でした。

汎用的な制御モデルとLLMの組み合わせによって、非常に人間に近い形でタスクを実行できているようになってきているのだと感じました。

新たな生成AI、新たな活用

この講演以外にも、LLMや3Dモデル生成といった生成AIの発表が見られました。今後は画像や言語、3Dモデルに限らず様々な生成AIが生まれてくると考えられます。

またGPT-4やWaabi Driver、NVIDIAの取り組みに見られるような生成AI・マルチモーダルAIが増える中、双方を組み合わせた新たな活用が増えることも予見されます。今後もAIの発展により一層注目していきたいと感じました。

担当者紹介

研究テーマ:人間拡張研究

担当者:伊藤 右貴

連絡先:NECソリューションイノベータ株式会社 イノベーション推進本部

ha-contact@nes.jp.nec.com